ollma

ollma

# 安装ollama

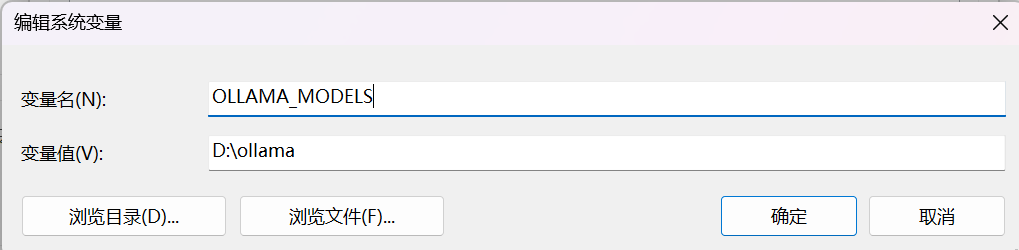

配置环境变量,模型会下载到此目录下

- 安装,完成后运行

ollama run llama3.1:8b它会自动下载模型并运行,不同的模型有不同的应用场景,模型简介可参考library (ollama.com) (opens new window)

# 配合open-webui使用

# 安装open-webui

- 如果您的计算机上安装了Ollama,可以使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 如果Ollama在另一台服务器上,请使用以下命令: 连接到另一台服务器上的Ollama时,请将OLLAMA_BASE_URL更改为服务器的URL:

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 要使用Nvidia GPU支持运行Open WebUI,请使用以下命令:

ocker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

- 如果您仅使用OpenAI API,请使用以下命令:

docker run -d -p 3000:8080 -e OPENAI_API_KEY=your_secret_key -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

登录

http://127.0.0.1:3000/即可访问了

# open-webui使用技巧

可以选择多个模型,然后对比输出结果

输入

#链接即可对链接里的内容进行总结